Robots.txt là gì? Hướng dẫn tạo file Robots.txt chuẩn SEO

File Robots.txt chính là "người gác cổng" quyết định Googlebot được phép "ghé thăm" những ngóc ngách nào trên website của bạn? Vậy Robots.txt là gì và làm thế nào để tạo một file Robots.txt chuẩn SEO, giúp Googlebot "thấy" được toàn bộ nội dung quan trọng trên website của bạn? Hãy cùng tìm hiểu ngay sau đây.

Robots.txt là gì?

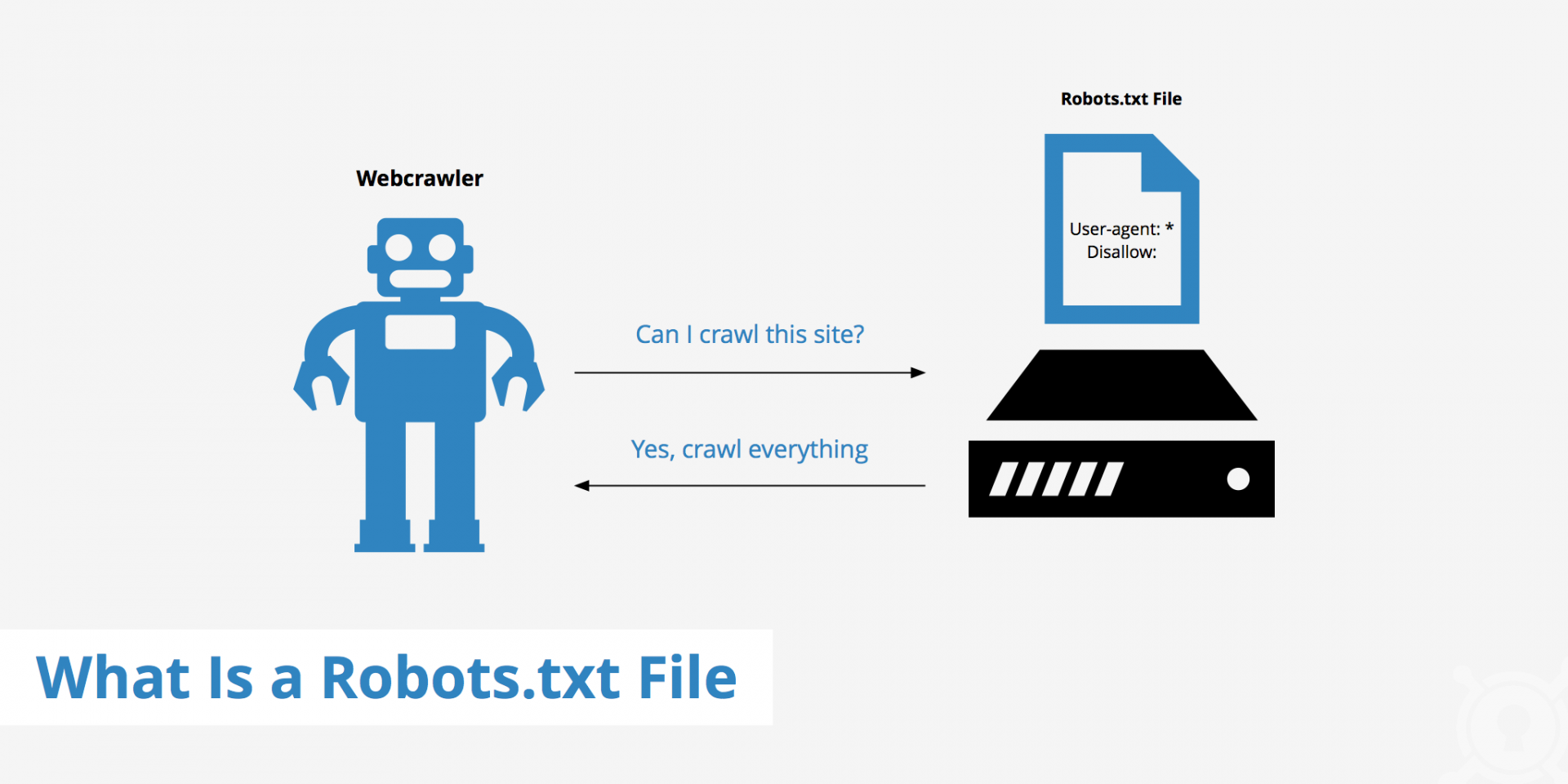

Robots.txt là một file văn bản được đặt trong thư mục gốc của website (ví dụ: domain.com/robots.txt), có chức năng "hướng dẫn" cho các công cụ tìm kiếm (trong đó có Google) về việc thu thập dữ liệu trên website. Nói một cách dễ hiểu, Robots.txt giống như một "bản đồ" chỉ dẫn cho Googlebot biết được:

-

Những trang nào trên website được phép thu thập (index).

-

Những trang nào không được phép thu thập (không index).

Trước khi bắt đầu "lần mò" vào bất kỳ website nào, Googlebot sẽ "ghé thăm" file Robots.txt trước tiên và tuân thủ theo những chỉ dẫn trong file này.

Tại sao phải chặn Googlebot lấy dữ liệu?

Chắc hẳn nhiều bạn sẽ thắc mắc: "Nếu không muốn Google index, tại sao phải đăng nội dung đó lên website?".

Thực tế là, có rất nhiều lý do chính đáng để chúng ta chặn Googlebot truy cập vào một số trang trên website, ví dụ như:

1. Chặn nội dung chưa hoàn chỉnh

Trong quá trình xây dựng website, việc "go live" (đưa website lên Internet) ngay cả khi nội dung chưa hoàn thiện là điều rất thường gặp. Điều này giúp bạn tiết kiệm thời gian và nhanh chóng đưa website tiếp cận với người dùng.

Tuy nhiên, bạn sẽ không muốn Google index những trang "chưa hoàn thiện" này, bởi nó có thể gây ảnh hưởng tiêu cực đến thứ hạng website của bạn trong tương lai. Lúc này, Robots.txt chính là "vị cứu tinh" giúp bạn "giấu" những trang này khỏi "con mắt" của Googlebot.

2. Đảm bảo nội dung quan trọng được tìm thấy

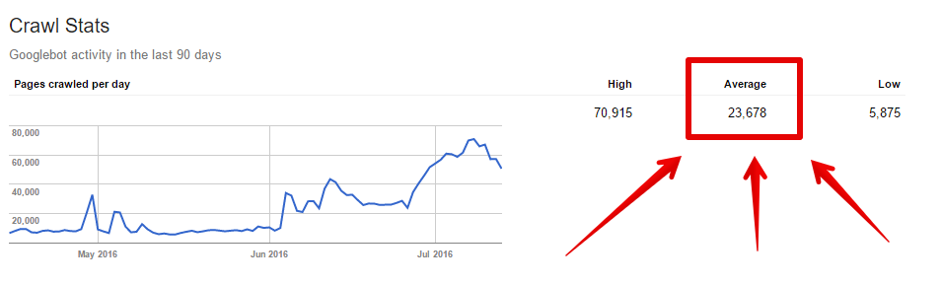

Google có một "ngân sách" thu thập dữ liệu (Crawl Budget) dành cho mỗi website. Điều này có nghĩa là Googlebot sẽ không thể "lần mò" và index toàn bộ các trang trên website của bạn, mà sẽ ưu tiên cho những trang thực sự chất lượng và hữu ích với người dùng.

Do đó, nếu website của bạn có quá nhiều nội dung không cần thiết (ví dụ: trang kết quả tìm kiếm nội bộ, trang lọc sản phẩm,...), bạn nên sử dụng Robots.txt để chặn Googlebot thu thập những trang này. Nhờ đó, Googlebot sẽ có thêm "thời gian" và "ngân sách" để tập trung vào những trang thực sự quan trọng trên website của bạn.

Ngoài ra, bạn có thể kết hợp sử dụng thẻ meta "noindex" được tích hợp trong Yoast SEO (hoặc các plugin SEO khác) để tăng thêm "sức mạnh" cho Robots.txt trong việc "che giấu" nội dung hiệu quả.

Hướng dẫn sử dụng Robots.txt

1. Kiểm tra Robots.txt hiện có

Để xem website của bạn đã có file Robots.txt hay chưa, bạn có thể truy cập vào đường dẫn: domain.com/robots.txt (thay domain.com bằng tên miền của bạn).

Dưới đây là ví dụ về một file Robots.txt:

User-agent: *

Sitemap: https://www.example.com/sitemap.xml

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Trong đó:

-

User-agent: Áp dụng cho tất cả các công cụ tìm kiếm.

-

Sitemap: Khai báo đường dẫn đến sitemap của website.

-

Disallow: Chặn công cụ tìm kiếm truy cập vào thư mục

/wp-admin/. -

Allow: Cho phép công cụ tìm kiếm truy cập vào file

/wp-admin/admin-ajax.php, mặc dù đã bị chặn bởi lệnhDisallow: /wp-admin/ở trên.

2. Chỉnh sửa file Robots.txt

Bạn có thể chỉnh sửa file Robots.txt bằng cách tạo một file mới hoặc sử dụng trực tiếp plugin Yoast SEO:

-

Tạo một file mới: Sử dụng bất kỳ trình soạn thảo văn bản nào (như Notepad, TextEditor,...), tạo một file mới tên là

robots.txtvà lưu trữ trong thư mục gốc của website. -

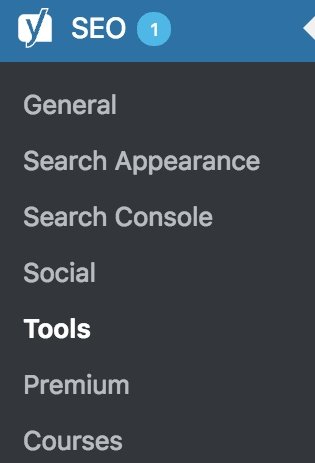

Sử dụng plugin Yoast SEO: Truy cập vào Yoast SEO > Tools > File editor.

Dưới đây là một số ví dụ về cách sử dụng các câu lệnh trong file Robots.txt:

- Chặn toàn bộ website:

User-agent: *

Disallow: /

- Chặn một trang cụ thể:

User-agent: *

Disallow: /ten-trang-can-chan/

- Chặn một thư mục cụ thể:

User-agent: *

Disallow: /ten-thu-muc-can-chan/

- Cho phép thu thập một trang cụ thể trong thư mục đã bị chặn:

User-agent: *

Disallow: /ten-thu-muc-da-bi-chan/

Allow: /ten-thu-muc-da-bi-chan/ten-trang-duoc-phep-thu-thap/

3. Cập nhật Robots.txt bằng Yoast SEO

Sau khi đã chỉnh sửa xong file Robots.txt, bạn cần cập nhật lại với Google:

-

Bước 1: Truy cập vào trang quản trị website và lưu lại file Robots.txt.

-

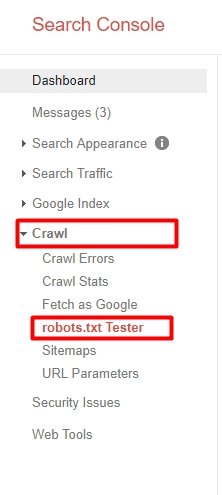

Bước 2: Đăng nhập vào Google Search Console và chọn website cần cập nhật.

-

Bước 3: Tại mục Legacy tools > Robots.txt Tester, dán nội dung file Robots.txt mới và nhấn nút "Submit".

Sau khi bạn nhấn "Submit", Google sẽ cần một khoảng thời gian để cập nhật lại file Robots.txt cho website của bạn.

Hy vọng rằng qua bài viết này, bạn đã hiểu rõ hơn về tầm quan trọng của file Robots.txt trong SEO và biết cách tạo một file Robots.txt chuẩn SEO, giúp website của bạn đạt được hiệu quả tối ưu nhất trên công cụ tìm kiếm Google.

Với giá cực tốt, bạn sẽ sở hữu dịch vụ Cloud Hosting ổ SSD tốc độ cao, an toàn và bảo mật. Đặc biệt, chúng tôi cung cấp bảng điều khiển cPanel dễ sử dụng và băng thông không giới hạn. Hãy trải nghiệm sự khác biệt với KDATA ngay hôm nay!

https://kdata.vn/cloud-hosting

👉 Liên hệ ngay KDATA hỗ trợ tận tình, support tối đa, giúp bạn trải nghiệm dịch vụ giá hời chất lượng tốt nhất

![[BLACKFRIDAY2024] KDATA sale 70% hoặc x2 thời hạn [BLACKFRIDAY2024] KDATA sale 70% hoặc x2 thời hạn](https://s3.kstorage.vn/api-kdata/images/banner/6733255e0aeb0.png)